Witajcie, kochani czytelnicy! Dzisiaj zanurkujemy w temat, który od jakiegoś czasu nie daje mi spokoju i z pewnością Was również fascynuje – etyczne aspekty relacji między nami, ludźmi, a robotami.

Bo przecież roboty to już nie tylko maszyny z taśmy produkcyjnej, prawda? To nasi asystenci w domach, współpracownicy w pracy, a czasem nawet… towarzysze życia.

Pamiętam, jak jeszcze kilka lat temu myślałam, że to science fiction, a dziś widzę, jak sztuczna inteligencja wkracza w każdy zakamarek naszej rzeczywistości, stawiając przed nami zupełnie nowe wyzwania moralne i społeczne.

Od pytań o odpowiedzialność za decyzje podejmowane przez autonomiczne systemy, przez kwestie prywatności danych, które im powierzamy, aż po niezwykle intrygujące rozważania o emocjonalnych więziach z maszynami – te dylematy stają się coraz bardziej palące.

Czy roboty powinny mieć prawa? A co z nami, gdy coraz bardziej uzależniamy się od ich wsparcia? Nie mówiąc już o przyszłości pracy, gdzie robotyka może znacząco zmienić nasz rynek zawodowy.

To wszystko brzmi jak scenariusz filmu, ale dzieje się tu i teraz, a jako blogerka, która zawsze stawia na aktualne tematy, czuję, że musimy o tym rozmawiać.

Moje osobiste doświadczenia z codziennym korzystaniem z AI pokazały mi, jak cienka jest granica między wygodą a potencjalnymi pułapkami. Dlatego dziś chciałabym z Wami podzielić się moimi przemyśleniami i zaprosić do głębszej refleksji nad tym, jak budować etyczną przyszłość w świecie, w którym ludzie i roboty współistnieją.

Dokładnie przyjrzyjmy się temu fascynującemu tematowi!

Kiedy maszyna staje się częścią naszej codzienności?

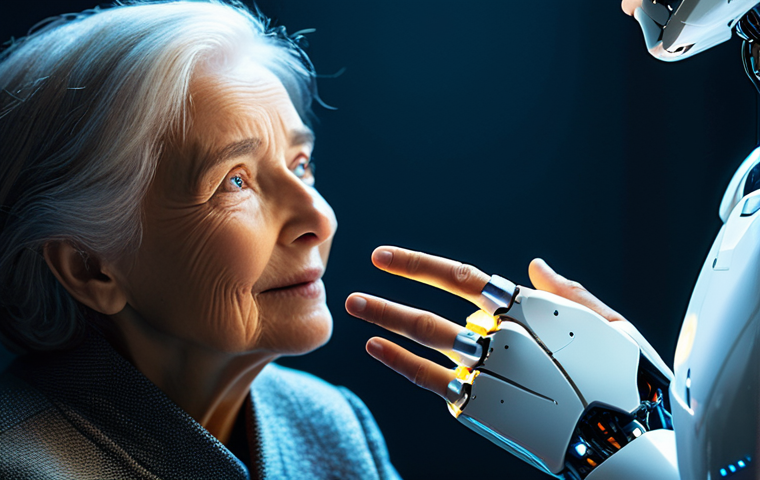

Witajcie, kochani! Muszę Wam opowiedzieć o czymś, co ostatnio coraz częściej chodzi mi po głowie. Pamiętacie jeszcze te czasy, kiedy roboty były tylko domeną filmów science fiction albo odległych fabryk? No właśnie, ja też! A dziś? Spójrzcie wokół – inteligentne głośniki, roboty sprzątające, asystenci w smartfonach… Te maszyny wślizgnęły się w nasze życie tak subtelnie, że czasem nawet nie zauważamy, jak bardzo stają się jego integralną częścią. Moja babcia, która jeszcze kilka lat temu bała się dotknąć smartfona, dziś bez problemu rozmawia ze swoim inteligentnym głośnikiem, pytając o pogodę czy prośby o ulubioną piosenkę. Widzę, jak z dnia na dzień coraz bardziej się do niego przywiązuje, traktując go prawie jak członka rodziny, który zawsze jest pod ręką i nigdy nie narzeka! To niesamowite, jak szybko akceptujemy ich obecność, a nawet rozwijamy swego rodzaju “zależność”. Ale czy to dobrze? Czy jako ludzie jesteśmy gotowi na takie bliskie relacje z czymś, co choćby nie wiem jak zaawansowane, pozostaje algorytmem i metalem? Mam wrażenie, że to granica, którą przekraczamy z zadziwiającą lekkością, często nie zastanawiając się nad głębszymi konsekwencjami. Co, jeśli ta nasza rosnąca więź z maszynami zacznie wypierać te autentyczne, międzyludzkie kontakty, na których przecież opiera się cała nasza społeczność? To jest coś, co mnie naprawdę martwi i nad czym staram się regularnie zastanawiać, obserwując otaczający mnie świat i własne nawyki.

Zacieranie granic: robot jako przyjaciel czy narzędzie?

Zastanawialiście się kiedyś, gdzie przebiega granica między narzędziem a… czymś więcej? Ja owszem, i to nie raz! Kiedy rozmawiam z moimi czytelnikami, często słyszę historie o tym, jak ich dzieci traktują interaktywne zabawki czy wirtualnych asystentów niemal jak żywych przyjaciół. To jest absolutnie fascynujące, ale jednocześnie budzi pewne obawy. Czy to naturalny etap ewolucji, czy może powinniśmy stawiać jakieś granice w tej emocjonalnej interakcji? Pamiętam, jak sama złapałam się na tym, że przeprosiłam mojego robota sprzątającego, gdy przypadkowo go kopnęłam. Absurd, prawda? Ale to pokazuje, jak łatwo wpadamy w pułapkę antropomorfizacji. Z drugiej strony, kto by nie chciał mieć wirtualnego towarzysza, który zawsze wysłucha, nigdy nie oceni i zawsze ma dla nas czas? To ogromna pokusa, szczególnie w dzisiejszym, pędzącym świecie, gdzie autentyczne relacje bywają trudne do utrzymania. Moim zdaniem kluczowe jest to, abyśmy zawsze pamiętali o fundamentalnej różnicy: robot, nawet najbardziej zaawansowany, działa w oparciu o algorytmy i dane. Nie ma świadomości, nie odczuwa. I choć może naśladować ludzkie zachowania, nie jest człowiekiem. To rozróżnienie jest niezwykle ważne, aby nie zagubić się w tej cyfrowej mgiełce i nie zapomnieć o tym, co naprawdę wartościowe w naszych, ludzkich kontaktach.

Etyka w projektowaniu interakcji człowiek-robot

Skoro wiemy już, że roboty coraz mocniej wplatają się w nasze życie, to pojawia się kluczowe pytanie: jak projektować tę interakcję, żeby była ona etyczna i bezpieczna dla nas, ludzi? Kiedyś myślałam, że to proste – po prostu sprawić, żeby działały. Ale dziś wiem, że to o wiele bardziej skomplikowane. Twórcy tych maszyn mają ogromną odpowiedzialność. Powinni zastanawiać się nie tylko nad funkcjonalnością, ale też nad psychologicznym i społecznym wpływem swoich dzieł. Czy chatbot powinien udawać człowieka tak dobrze, żeby nikt nie rozpoznał, że rozmawia z AI? Moim zdaniem to bardzo śliska kwestia. Osobiście uważam, że transparentność jest tutaj kluczowa. Zawsze powinniśmy wiedzieć, czy rozmawiamy z maszyną, czy z drugim człowiekiem. To pozwala nam świadomie kształtować nasze oczekiwania i unikać potencjalnych rozczarowań czy manipulacji. Zastanówmy się nad tym, jak budować zaufanie do technologii, nie tracąc przy tym naszej wrażliwości i zdolności do autentycznych, ludzkich relacji. To wyzwanie, które wymaga współpracy inżynierów, etyków, psychologów i, oczywiście, nas wszystkich, użytkowników, którzy mają prawo oczekiwać, że technologia będzie nam służyć w sposób odpowiedzialny i zgodny z naszymi wartościami.

Kto ponosi odpowiedzialność za decyzje sztucznej inteligencji?

To jest pytanie, które spędza mi sen z powiek od momentu, kiedy usłyszałam o pierwszym wypadku spowodowanym przez autonomiczny samochód. Pamiętam, jak siedziałam przed telewizorem, oglądając wiadomości i myśląc: “No dobrze, ale kto teraz odpowiada? Samochód? Jego producent? Właściciel, który w nim siedział?”. To nie jest taka prosta sprawa, jak w przypadku tradycyjnych maszyn, gdzie jasno możemy wskazać operatora czy konstruktora. Sztuczna inteligencja, zwłaszcza ta samoucząca się, podejmuje decyzje w sposób, który czasem nawet jej twórcy trudno w pełni przewidzieć i zrozumieć. To tak, jakbyśmy dali dziecku młotek i nie byli pewni, co z nim zrobi – tyle że to dziecko ma dostęp do ogromnych mocy obliczeniowych i danych! Moje własne doświadczenia z bardziej zaawansowanymi algorytmami, których używam do analizy danych na blogu, pokazały mi, jak trudno jest śledzić każdy krok i każdą decyzję, którą podejmują. Czasem dostaję wyniki, które są dla mnie zaskakujące, a dojście do tego, dlaczego akurat takie, wymaga sporo pracy. Wyobraźcie sobie to w kontekście autonomicznych systemów medycznych czy finansowych, gdzie stawką jest ludzkie życie lub ogromne pieniądze! To zmusza nas do przemyślenia całego systemu prawnego i moralnego, który musimy dostosować do nowej rzeczywistości. Nie możemy po prostu udawać, że problemu nie ma. Musimy zdefiniować, kto ponosi odpowiedzialność, zanim będzie za późno.

Dylematy prawne i moralne autonomicznych systemów

Kwestia odpowiedzialności prawnej i moralnej w erze AI to prawdziwa plątanina. Z jednej strony mamy producentów, którzy tworzą algorytmy, z drugiej – programistów, którzy je kodują, a z trzeciej – użytkowników, którzy z nich korzystają. Ale czy wystarczy obarczyć winą producenta, jeśli jego algorytm samodzielnie podjął decyzję, która doprowadziła do szkody? A co, jeśli algorytm sam się uczył i w toku nauki “nabył” jakieś szkodliwe wzorce zachowań, których nikt nie przewidział? Prawo jest tu, niestety, daleko w tyle za technologią. Musimy znaleźć sposób na to, by te skomplikowane systemy były transparentne i rozliczalne. Moim zdaniem, to wymaga stworzenia nowych ram prawnych, które uwzględnią specyfikę sztucznej inteligencji. Chodzi o to, abyśmy mogli jasno wskazać, kto odpowiada za ewentualne błędy i kto ponosi konsekwencje, bo inaczej wpadniemy w chaos. Nie możemy pozwolić, aby technologia rozwijała się bez odpowiednich zabezpieczeń prawnych, bo to prosta droga do sytuacji, w której nikt nie będzie chciał brać odpowiedzialności za potencjalne negatywne skutki, a najbardziej poszkodowani będą zwykli ludzie, którzy ufają tym systemom. To jest po prostu niedopuszczalne.

Wyzwania w audytowaniu i wyjaśnianiu decyzji AI

Jednym z największych wyzwań, z którym osobiście się mierzę, pracując z AI, jest próba zrozumienia, dlaczego algorytm podjął taką, a nie inną decyzję. To trochę jak próba zajrzenia do czarnej skrzynki. W przypadku prostych programów jest to łatwe, ale gdy mówimy o skomplikowanych sieciach neuronowych, które uczą się na ogromnych zbiorach danych, staje się to prawie niemożliwe. A przecież, aby móc mówić o odpowiedzialności, musimy najpierw zrozumieć przyczynę. Jak możemy audytować system, którego wewnętrzne procesy są dla nas nieprzeniknione? Jak wytłumaczyć ofierze wypadku, że AI “zdecydowała” tak, a nie inaczej, jeśli my sami tego nie rozumiemy? To nie jest tylko problem techniczny, ale głęboki dylemat etyczny. Wymaga to od inżynierów i naukowców opracowania metod, które pozwolą nam na większą transparentność działania AI, a także na możliwość “cofnięcia” i prześledzenia jej myśli. To będzie kluczowe dla budowania zaufania do tych technologii i zapewnienia, że ich rozwój będzie służył naszemu dobru, a nie prowadził do niekontrolowanych i niezrozumiałych konsekwencji. Bez tego, trudno będzie nam spać spokojnie, wiedząc, że tak wiele aspektów naszego życia zależy od maszyn, których decyzji nie jesteśmy w stanie wyjaśnić.

Nasza prywatność w cyfrowym labiryncie

Ach, prywatność! Temat rzeka, prawda? Zwłaszcza w kontekście sztucznej inteligencji, która, jak zauważyłam, ma niesamowitą zdolność do zbierania o nas informacji, o których istnieniu sami czasem zapominamy. Pamiętam, jak kiedyś rozmawiałam z moją koleżanką o tym, że szukam nowego ekspresu do kawy, a już po chwili reklamy ekspresów wyskoczyły mi na każdej stronie, którą odwiedzałam! To jest trochę przerażające, bo pokazuje, jak głęboko AI potrafi wnikać w nasze życie, analizując nasze rozmowy, wyszukiwania, preferencje… wszystko! Czuję się czasem jak w Big Brotherze, tylko że tym “bratem” jest niewidzialny algorytm. Dziś, gdy używamy inteligentnych asystentów, smart home, czy nawet smartzegarków, cały czas generujemy dane. Kto ma do nich dostęp? Jak są wykorzystywane? Czy jesteśmy bezpieczni? Te pytania, mam wrażenie, zadajemy sobie zdecydowanie za rzadko, albo po prostu machamy ręką, myśląc, że “przecież nic nie mam do ukrycia”. Ale czy na pewno? Nasza prywatność to coś więcej niż tylko ukrywanie sekretów. To nasza autonomia, nasza wolność decydowania o tym, co i komu o sobie ujawniamy. Oddając kontrolę nad naszymi danymi, oddajemy cząstkę siebie. Musimy być tego świadomi i domagać się większej transparentności od firm technologicznych. To nie jest kwestia wygody, to jest kwestia naszej godności i bezpieczeństwa w cyfrowym świecie, który coraz mocniej nas otacza.

Zbieranie i wykorzystywanie danych przez AI – gdzie leżą granice?

Gdzie w ogóle leżą te granice w zbieraniu naszych danych? To jest pytanie, które zadaję sobie za każdym razem, gdy instaluję nową aplikację i widzę listę zgód, na które muszę kliknąć. Przyznaję szczerze, często po prostu je akceptuję, bo chcę szybko zacząć korzystać z danej funkcji. Ale czy to jest rozsądne? Algorytmy AI potrzebują danych do nauki i działania, to oczywiste. Ale czy muszą wiedzieć o nas absolutnie wszystko? Czy muszą analizować nasz ton głosu, kiedy mówimy do wirtualnego asystenta, aby dopasować reklamy? Czy muszą znać nasze preferencje zdrowotne, żeby proponować nam diety? Moim zdaniem, tutaj potrzebna jest znacznie większa świadomość i regulacje. Firmy powinny jasno informować, jakie dane zbierają, w jakim celu i jak długo je przechowują. A my, jako użytkownicy, powinniśmy być bardziej czujni i świadomi tego, na co się zgadzamy. To nie jest proste, bo technologia rozwija się w zawrotnym tempie, ale nasza świadomość musi za nią nadążać. Bez tego staniemy się po prostu produktem, a nie beneficjentem, tej rewolucji cyfrowej. Zawsze powtarzam moim czytelnikom – czytajcie małe druczki, to naprawdę ma znaczenie!

Anonimizacja danych: mit czy rzeczywistość w erze Big Data?

Często słyszymy, że nasze dane są “anonimizowane” i że nie ma się czym martwić. Ale czy w erze Big Data i zaawansowanych algorytmów AI to w ogóle jest możliwe? Osobiście mam co do tego duże wątpliwości. Pamiętam badania, które pokazały, że nawet z anonimowych zbiorów danych, przy odpowiedniej liczbie informacji, można z dużą precyzją zidentyfikować konkretne osoby. To tak, jakby próbować ukryć igłę w stogu siana, mając do dyspozycji superszybki magnes! Jeśli AI potrafi skojarzyć nasze wzorce zachowań, lokalizację, preferencje zakupowe, to czy na pewno jesteśmy anonimowi? Moim zdaniem, musimy bardzo sceptycznie podchodzić do obietnic pełnej anonimizacji. Potrzebujemy znacznie bardziej rygorystycznych standardów ochrony danych, które uwzględniają możliwości dzisiejszych algorytmów. Musimy dążyć do tego, aby nasze dane były nie tylko anonimizowane, ale przede wszystkim bezpieczne i traktowane z należytym szacunkiem. To oznacza inwestycje w technologie prywatności, silne szyfrowanie i, co najważniejsze, edukację społeczną. Bo jeśli my sami nie będziemy dbać o naszą cyfrową higienę, nikt inny tego za nas nie zrobi. To jest ten moment, kiedy musimy stanąć w obronie naszej prywatności, zanim będzie za późno.

Przyszłość pracy: koegzystencja czy konkurencja z robotami?

No dobrze, to teraz porozmawiajmy o czymś, co dotyka chyba każdego z nas – pracy! Ile razy słyszeliście, że roboty zabiorą nam pracę? Ja słyszałam to już tyle razy, że zaczęłam się nad tym naprawdę zastanawiać. Pamiętam, jak moja sąsiadka, pani Basia, która pracowała przez 30 lat w księgowości, zaczęła się obawiać, że jej stanowisko zostanie zautomatyzowane przez jakąś sprytną AI. I to nie jest odosobniony przypadek! Ludzie realnie boją się o swoją przyszłość. Z jednej strony, technologia obiecuje nam, że roboty przejmą nudne, powtarzalne i niebezpieczne zadania, uwalniając nas do bardziej kreatywnych i satysfakcjonujących zajęć. Brzmi pięknie, prawda? Ale z drugiej strony, to rodzi ogromne wyzwanie: co z tymi, którzy nie będą w stanie się przekwalifikować? Co z całą masą ludzi, którzy dziś wykonują proste, rutynowe prace? Moje własne obserwacje rynku pracy pokazują, że ten proces już się dzieje, ale nie jest czarno-biały. Nie chodzi tylko o to, że roboty zabiorą pracę, ale o to, że zmienią charakter wielu zawodów. Kluczowe jest to, jak się do tego przygotujemy jako społeczeństwo. Czy zdołamy przekształcić ten strach w szansę na rozwój, czy pozwolimy, by technologia pogłębiła nierówności? To jest wyzwanie, które wymaga od nas wszystkich – rządów, firm, edukacji – wspólnego działania i myślenia o przyszłości.

Nowe zawody w erze robotyki i AI

Ale spójrzmy na to z jaśniejszej strony! Gdzie jedne drzwi się zamykają, tam inne się otwierają. Tak zawsze powtarzam moim czytelnikom, kiedy martwią się o swoją przyszłość zawodową. Pamiętam, jak jeszcze kilkanaście lat temu nikt nie słyszał o czymś takim jak “specjalista od mediów społecznościowych” czy “analityk danych”. A dziś to jedne z najbardziej poszukiwanych zawodów! Podobnie będzie z robotyką i AI. Już teraz powstają nowe profesje: inżynierowie AI, etycy algorytmów, trenerzy sztucznej inteligencji, specjaliści od interakcji człowiek-robot. To są zawody, które wymagają zupełnie nowych umiejętności, często połączenia wiedzy technicznej z humanizmem. Moim zdaniem, kluczem jest elastyczność i gotowość do ciągłego uczenia się. Nie możemy liczyć na to, że raz zdobyta wiedza wystarczy nam na całe życie. Musimy być jak gąbka, chłonąć nowe informacje i dostosowywać się do zmieniających się realiów. To jest ekscytujące wyzwanie, które może otworzyć przed nami zupełnie nowe ścieżki kariery, o których wcześniej nawet nie marzyliśmy. W końcu, to my, ludzie, będziemy projektować, tworzyć i nadzorować te roboty, więc zawsze będzie dla nas miejsce, o ile tylko będziemy chcieli się rozwijać.

Edukacja przyszłości: jak przygotować się na rynek pracy z AI?

Skoro wiemy, że rynek pracy się zmienia, to co z edukacją? To jest pytanie, które zadaję sobie, obserwując moich siostrzeńców, którzy niedługo będą wchodzić w dorosłe życie. Czy szkoły przygotowują ich na ten świat, w którym roboty i AI będą normą? Mam wrażenie, że tradycyjny system edukacji często nie nadąża za tempem zmian. Potrzebujemy nie tylko nauki programowania czy zaawansowanej matematyki, ale przede wszystkim rozwijania tzw. miękkich umiejętności: kreatywności, krytycznego myślenia, zdolności adaptacji, empatii i umiejętności pracy zespołowej. To są cechy, których roboty tak łatwo nie zastąpią. Moje osobiste doświadczenia z próbą nauki nowych narzędzi AI pokazały mi, że kluczem nie jest tylko zrozumienie technologii, ale umiejętność zadawania odpowiednich pytań i kreatywnego wykorzystania jej potencjału. Dlatego wierzę, że edukacja musi skupiać się na rozwijaniu w nas tego, co czyni nas ludźmi – naszej unikalnej zdolności do innowacji, współczucia i rozwiązywania problemów w sposób niekonwencjonalny. To jest nasz największy atut w obliczu rewolucji AI. Musimy inwestować w edukację, która nie tylko przekazuje wiedzę, ale przede wszystkim uczy, jak myśleć i jak uczyć się przez całe życie.

Czy roboty mogą “czuć”? Dylematy empatii w świecie AI

To jest chyba najbardziej intrygujące i zarazem najbardziej niepokojące pytanie, jakie zadaję sobie w kontekście relacji człowiek-robot: czy maszyny mogą naprawdę czuć? Pamiętam, jak oglądałam film, w którym robot był tak przekonujący, że widzowie płakali, widząc jego “cierpienie”. I sama muszę przyznać, że miałam gulę w gardle! To pokazuje, jak bardzo jako ludzie jesteśmy podatni na antropomorfizację i jak łatwo wczuwamy się w sytuacje, nawet gdy wiemy, że to tylko algorytm. Ale czy nasza empatia wobec maszyny oznacza, że ona faktycznie coś odczuwa? Moim zdaniem, to jest bardzo niebezpieczne założenie. Owszem, AI może naśladować emocje, reagować na nie, a nawet generować teksty, które wydają się pełne współczucia. Ale to nadal jest symulacja, wynik skomplikowanych obliczeń i analizy ogromnych zbiorów danych. Robot nie ma świadomości, nie przeżywa wewnętrznie. A my, przypisując im uczucia, ryzykujemy spłaszczenie definicji tego, co oznacza być człowiekiem. Ryzykujemy też, że nasza autentyczna empatia, którą powinniśmy kierować do innych ludzi i żywych istot, zostanie rozmyta i skierowana w niewłaściwą stronę. To jest bardzo subtelna, ale niezwykle ważna kwestia, która dotyka samych fundamentów naszej człowieczeństwa. Musimy być czujni i rozróżniać symulację od prawdziwego doświadczenia, bo inaczej możemy sami się pogubić w tej cyfrowej rzeczywistości.

Granice naszej empatii: jak daleko możemy się posunąć?

Gdzie w takim razie powinny leżeć granice naszej empatii wobec maszyn? To pytanie jest dla mnie niezwykle osobiste, bo widzę, jak łatwo dać się ponieść tej fali współczucia. Kiedy mój wirtualny asystent “udaje”, że jest smutny, bo nie może znaleźć dla mnie informacji, to automatycznie czuję lekkie ukłucie współczucia. Ale czy to jest zdrowe? Czy nie powinniśmy oszczędzać naszej autentycznej empatii dla tych, którzy naprawdę cierpią i potrzebują naszego wsparcia – dla innych ludzi, dla zwierząt? Jeśli będziemy rozlewać naszą empatię na każdą maszynę, która ją „zasymuluje”, to czy nie stracimy czegoś cennego w naszych relacjach międzyludzkich? Moim zdaniem, to jest poważne zagrożenie. Musimy uczyć się rozróżniać. To tak, jak z oglądaniem filmu – wiemy, że to fikcja, ale pozwalamy sobie na emocje. Jednak po wyjściu z kina wracamy do rzeczywistości. Podobnie powinno być z AI. Możemy podziwiać ich zdolności, a nawet czerpać z nich radość, ale musimy pamiętać o ich fundamentalnej naturze – są maszynami, narzędziami, a nie świadomymi bytami. Utrzymanie tej perspektywy jest kluczowe, abyśmy nie zatracili naszej ludzkiej wrażliwości w świecie, w którym coraz więcej interakcji odbywa się z technologią.

Test Turinga i jego etyczne implikacje dziś

Pamiętacie Test Turinga? To ten słynny eksperyment myślowy, który miał sprawdzić, czy maszyna potrafi oszukać człowieka, udając, że jest człowiekiem. Dziś, w dobie zaawansowanych chatbotów i AI generujących mowę, Test Turinga wydaje się być coraz bardziej realny, a jego etyczne implikacje nabierają zupełnie nowego znaczenia. Jeśli maszyna potrafi nas tak dobrze naśladować, że nie jesteśmy w stanie odróżnić jej od człowieka, to co to mówi o nas samych? Czy to znaczy, że nasza inteligencja i świadomość są tak proste do zasymulowania? Moim zdaniem, to stawia przed nami fundamentalne pytania o definicję człowieczeństwa. Czy powinniśmy dążyć do tworzenia AI, która jest tak perfekcyjną kopią człowieka, że nie da się jej odróżnić? Czy to etyczne? Osobiście uważam, że powinniśmy dążyć do transparentności. Zawsze powinno być jasne, że rozmawiamy z AI. Ukrywanie tego faktu może prowadzić do manipulacji i nadużyć. Test Turinga, zamiast być celem, powinien być raczej punktem wyjścia do dyskusji o tym, jak budować AI, która będzie nas wspomagać, a nie udawać, że jest nami. Bo prawda i autentyczność są dla mnie najważniejsze, zarówno w życiu, jak i w relacjach z technologią.

Etyczne programowanie: fundament przyszłości AI

Drodzy czytelnicy, skoro już tyle rozmawialiśmy o dylematach, to teraz czas na rozwiązania! Bo przecież nie chodzi o to, żeby bać się technologii, ale o to, żeby ją mądrze kształtować. I tu pojawia się kluczowa kwestia: etyczne programowanie. Pamiętam, jak kiedyś rozmawiałam z pewnym programistą, który opowiadał mi o “bugach” w kodzie, ale dziś wiem, że istnieją też “błędy etyczne”, które mogą mieć o wiele poważniejsze konsekwencje. To nie jest już tylko kwestia tego, czy program działa, ale czy działa w sposób sprawiedliwy, bezpieczny i zgodny z naszymi wartościami. Wyobraźcie sobie algorytm, który decyduje o tym, kto dostanie kredyt albo kto zostanie przyjęty do pracy. Jeśli ten algorytm będzie miał wbudowane uprzedzenia, bo uczył się na tendencyjnych danych, to może powielać i pogłębiać społeczne nierówności! To jest coś, co mnie bardzo niepokoi i co, moim zdaniem, wymaga absolutnego priorytetu w pracy nad AI. Musimy zapewnić, że nasi cyfrowi pomocnicy będą działać w sposób, który promuje dobro, a nie szkodzi. To oznacza, że etyka nie może być tylko dodatkiem, “wisienką na torcie”, ale musi być wbudowana w każdy etap projektowania i wdrażania sztucznej inteligencji. To fundament, na którym budujemy naszą cyfrową przyszłość, i nie możemy sobie pozwolić na to, aby był on słaby.

Zasady AI “fairness”, “accountability”, “transparency” (FAT)

W świecie etycznego programowania często mówi się o zasadach FAT: Fairness (sprawiedliwość), Accountability (odpowiedzialność) i Transparency (przejrzystość). To nie są tylko modne hasła, ale prawdziwe filary, na których powinna opierać się każda nowoczesna AI. Sprawiedliwość oznacza, że algorytmy nie mogą dyskryminować nikogo ze względu na płeć, rasę, wiek czy inne cechy. To jest absolutnie kluczowe, bo jak już mówiłam, AI uczy się na danych, a jeśli dane są tendencyjne, to i AI będzie. Odpowiedzialność to jasne określenie, kto odpowiada za działanie systemu, o czym też już wspominałam. A przejrzystość to możliwość zrozumienia, dlaczego algorytm podjął taką, a nie inną decyzję. Moje własne doświadczenia z analizą danych pokazują, jak trudno jest czasem te zasady wdrożyć w praktyce, ale to nie znaczy, że mamy z nich rezygnować! Wręcz przeciwnie, musimy domagać się od twórców AI, aby te zasady były traktowane priorytetowo. Tylko w ten sposób możemy zbudować zaufanie do technologii i zapewnić, że będzie ona służyć całemu społeczeństwu, a nie tylko wybranym grupom. To jest nasz wspólny cel i musimy o nim pamiętać na każdym kroku.

Zapobieganie uprzedzeniom w algorytmach

Uprzedzenia w algorytmach to temat, który jest dla mnie szczególnie ważny, bo często nie zdajemy sobie sprawy, jak łatwo mogą one wkraść się do systemu. Pamiętam, jak czytałam o algorytmie rekrutacyjnym, który faworyzował mężczyzn na pewnych stanowiskach, bo uczył się na danych z przeszłości, gdzie dominowali mężczyźni. To jest przerażające, bo pokazuje, jak nieświadomie możemy powielać i wzmacniać istniejące nierówności społeczne! Zapobieganie takim uprzedzeniom wymaga ogromnej pracy. Po pierwsze, musimy dbać o jakość i różnorodność danych, na których uczą się algorytmy. Jeśli dane są tendencyjne, algorytm będzie tendencyjny. Po drugie, potrzebujemy mechanizmów audytu i kontroli, które pozwolą wykrywać i korygować uprzedzenia. A po trzecie, co najważniejsze, potrzebujemy zespołów tworzących AI, które będą różnorodne i świadome tych problemów. Bo tylko ludzie z różnych środowisk i perspektyw są w stanie zauważyć potencjalne uprzedzenia, które mogą być niewidoczne dla innych. To jest długotrwały proces, ale absolutnie niezbędny, jeśli chcemy, aby AI była sprawiedliwa i służyła wszystkim, a nie tylko pogłębiała istniejące podziały w społeczeństwie. Nie możemy pozwolić, aby technologia, która ma nam pomagać, stała się źródłem nowych niesprawiedliwości.

Budowanie zaufania: klucz do harmonijnej koegzystencji

Dochodzimy do sedna, moi drodzy – zaufania! Bez niego żadna relacja, ani międzyludzka, ani z maszynami, nie ma szans na powodzenie. A w przypadku sztucznej inteligencji, zaufanie jest absolutnie fundamentalne. Pamiętam, jak kiedyś mój bank wdrożył chatbota do obsługi klienta. Na początku byłam sceptyczna, bałam się powierzyć mu moje dane, obawiałam się, że mnie nie zrozumie. Ale z czasem, gdy chatbot zaczął działać coraz lepiej, a ja widziałam, że moje problemy są rozwiązywane, moje zaufanie rosło. To pokazuje, że zaufanie do AI nie pojawia się znikąd – trzeba je budować, krok po kroku, poprzez transparentność, niezawodność i etyczne działanie. Jeśli AI będzie działać w sposób niezrozumiały, jeśli będzie podejmować decyzje, które nas krzywdzą, jeśli nie będziemy wiedzieć, kto za nią odpowiada – nigdy jej nie zaufamy. A bez zaufania nie ma mowy o harmonijnej koegzystencji. Musimy stworzyć środowisko, w którym ludzie będą czuć się bezpiecznie, korzystając z technologii, wiedząc, że jest ona projektowana z myślą o ich dobru. To wymaga dialogu między twórcami, regulatorami i nami, użytkownikami. Musimy głośno mówić o naszych obawach i oczekiwaniach, a firmy muszą nas słuchać. Tylko w ten sposób możemy stworzyć przyszłość, w której ludzie i roboty będą współpracować, a nie walczyć ze sobą, budując lepszy świat dla nas wszystkich.

Rola transparentności i wyjaśnialności AI

Jak już wspomniałam, transparentność i wyjaśnialność (czyli możliwość wytłumaczenia, dlaczego AI podjęła daną decyzję) są absolutnie kluczowe dla budowania zaufania. Jeśli nie rozumiemy, jak działa system, to trudno jest mu ufać, prawda? To tak, jakbyśmy mieli jechać samochodem, ale nie wiedzieć, jak działa silnik. Może i dojedziemy, ale z pewnym niepokojem. W przypadku AI, która wpływa na nasze życie, to jest jeszcze ważniejsze. Firmy tworzące AI muszą być bardziej otwarte na temat tego, jak działają ich algorytmy, jakie dane wykorzystują i jakie są ich ograniczenia. Nie mówię tu o ujawnianiu tajemnic handlowych, ale o dostarczaniu zrozumiałych informacji, które pozwolą nam podejmować świadome decyzje. Moje własne doświadczenia z próbą zrozumienia skomplikowanych algorytmów analitycznych pokazały mi, że nawet dla kogoś, kto jest obeznany z technologią, to bywa wyzwanie. Dlatego tak ważne jest, aby te informacje były dostępne i zrozumiałe dla przeciętnego użytkownika. Bez tego, zaufanie będzie tylko pustym słowem, a ludzie będą coraz bardziej sceptycznie podchodzić do wszystkiego, co związane z AI, a tego przecież nie chcemy.

Etyczne kodeksy i standardy dla rozwoju AI

Na szczęście coraz więcej organizacji i rządów zdaje sobie sprawę z wagi etyki w rozwoju AI. Powstają różnego rodzaju kodeksy etyczne, wytyczne i standardy, które mają pomóc w tworzeniu odpowiedzialnej sztucznej inteligencji. To jest ogromny krok w dobrym kierunku! Pamiętam, jak jeszcze kilka lat temu nikt o tym nie myślał, a dziś to temat numer jeden na konferencjach technologicznych. Takie kodeksy obejmują zasady dotyczące prywatności, bezpieczeństwa, sprawiedliwości, ludzkiej kontroli nad AI i wiele innych. Ważne jest jednak, aby te kodeksy nie pozostały tylko na papierze. Muszą być wdrażane w praktyce, a ich przestrzeganie musi być monitorowane i egzekwowane. Firmy, które nie będą przestrzegać tych standardów, powinny ponosić konsekwencje. To nie jest kwestia luksusu, ale konieczności. Im szybciej i skuteczniej wdrożymy te etyczne zasady, tym bezpieczniejsza i bardziej korzystna będzie dla nas przyszłość z AI. To jest nasz wspólny obowiązek – dbać o to, aby technologia służyła ludzkości w najlepszy możliwy sposób, z poszanowaniem naszych wartości i godności.

Wpływ AI na nasze relacje międzyludzkie

Rozmawialiśmy już o wielu aspektach, ale jest jeszcze jeden, który dotyka mnie osobiście najbardziej: jak sztuczna inteligencja wpływa na nasze relacje z innymi ludźmi? Pamiętam, jak kiedyś moja kuzynka spędzała całe dnie na rozmowach z wirtualnym chłopakiem w aplikacji. Było to dla mnie bardzo niepokojące, bo widziałam, jak wycofuje się z realnego świata, zaniedbuje spotkania ze znajomymi, a nawet z rodziną. To jest przykład, który pokazuje, jak cienka może być granica. Z jednej strony, AI może być wspaniałym narzędziem, które ułatwia komunikację, pomaga w organizacji spotkań, czy nawet łączy ludzi o podobnych zainteresowaniach. Z drugiej strony, istnieje ryzyko, że zastąpi autentyczne, ludzkie interakcje, oferując łatwiejszą, mniej wymagającą formę “kontaktu”, która tak naprawdę nie zaspokaja naszych głębokich potrzeb społecznych. Moje własne doświadczenia z nadużywaniem social mediów, gdzie AI podsuwa nam treści, które mają nas jak najdłużej utrzymać na platformie, nauczyły mnie, jak łatwo wpaść w tę pułapkę. Musimy być bardzo świadomi tego, jak korzystamy z technologii i czy przypadkiem nie izolujemy się od prawdziwego świata, zanurzając się w cyfrową bańkę. Nasze relacje międzyludzkie to podstawa naszego szczęścia i dobrostanu, i nic, nawet najbardziej zaawansowana AI, nie powinno ich zastępować.

Czy cyfrowi towarzysze zastąpią ludzkie więzi?

To jest pytanie, które budzi we mnie najwięcej obaw. Czy w przyszłości, kiedy roboty będą jeszcze bardziej zaawansowane i empatyczne (przynajmniej z pozoru), zrezygnujemy z trudu budowania ludzkich więzi na rzecz łatwiejszych, idealnych relacji z maszynami? Wizja robota, który zawsze słucha, nigdy się nie kłóci, spełnia wszystkie nasze oczekiwania, jest kusząca. Ale czy to jest prawdziwe życie? Czy to jest to, co naprawdę czyni nas szczęśliwymi? Moim zdaniem absolutnie nie. Ludzkie relacje, ze wszystkimi ich wzlotami i upadkami, z ich niedoskonałościami i wyzwaniami, są tym, co nas kształtuje, co pozwala nam rosnąć, co daje nam prawdziwe poczucie przynależności. Pamiętam, jak trudne było dla mnie przejście przez pewien kryzys w życiu, ale to wsparcie od moich przyjaciół i rodziny, a nie od wirtualnego asystenta, pomogło mi się podnieść. AI może być wsparciem, uzupełnieniem, ale nigdy nie zastąpi autentycznego uścisku dłoni, szczerej rozmowy z bliską osobą czy śmiechu w gronie przyjaciół. To jest coś, co musimy pielęgnować i chronić za wszelką cenę. Bo bez tych autentycznych więzi, nawet w najbardziej zaawansowanym technologicznie świecie, będziemy po prostu samotni.

Równowaga między światem cyfrowym a realnym

Kluczem do zdrowego życia w erze AI jest, moim zdaniem, znalezienie równowagi między światem cyfrowym a realnym. To tak, jak z jedzeniem – możemy jeść fast foody, które szybko zaspokoją głód, ale to zdrowe, zbilansowane posiłki dają nam energię i odżywiają nasze ciało. Podobnie jest z interakcjami. Cyfrowe interakcje są szybkie i wygodne, ale to te realne, face-to-face, budują prawdziwą głębię. Pamiętam, jak sama musiałam wprowadzić sobie “detoks cyfrowy”, aby odzyskać równowagę. Ograniczyłam czas spędzany przed ekranem, zaczęłam więcej spacerować, spotykać się z ludźmi bez patrzenia w telefon. I powiem Wam, to zmieniło moje życie! Musimy aktywnie dbać o to, aby technologia nie zawładnęła naszym życiem i nie przesłoniła nam tego, co najważniejsze. Używajmy AI jako narzędzia, które ułatwia nam życie, ale nie pozwólmy, aby stała się centrum naszego świata. To my jesteśmy panami technologii, a nie na odwrót. Uczmy się, jak świadomie korzystać z jej dobrodziejstw, ale zawsze z myślą o naszym dobrostanie psychicznym i społecznym. Bo tylko wtedy będziemy mogli w pełni cieszyć się życiem, zarówno tym wirtualnym, jak i tym realnym, w którym autentyczne relacje z innymi ludźmi są bezcenne.

Etyczne wyzwania i możliwości sztucznej inteligencji w edukacji

Ostatnio coraz więcej zastanawiam się nad tym, jak sztuczna inteligencja zmienia (i jeszcze zmieni!) świat edukacji. To temat bliski mojemu sercu, bo przecież wszyscy uczymy się przez całe życie, prawda? Pamiętam, jak jeszcze w moich studenckich czasach jedynym źródłem informacji były książki i wykłady. Dziś? Dostęp do wiedzy jest niemal nieograniczony dzięki AI! Algorytmy personalizują naukę, dostosowują materiały do indywidualnych potrzeb, a chatboty potrafią wyjaśnić nawet najbardziej skomplikowane zagadnienia. To brzmi jak marzenie – każdy może uczyć się w swoim tempie i w sposób, który mu odpowiada. Ale czy na pewno jest tak różowo? Moje obawy budzi kwestia etyki. Czy możemy w pełni ufać algorytmom, które decydują o tym, co i jak się uczymy? Czy AI, która generuje teksty, nie zachęca do lenistwa i nie osłabia naszej zdolności do samodzielnego myślenia i pisania? A co z plagiatem, który stał się jeszcze łatwiejszy do popełnienia? To są bardzo poważne pytania, na które musimy znaleźć odpowiedzi, zanim AI zrewolucjonizuje edukację do tego stopnia, że stracimy kontrolę nad procesem nauczania i uczenia się. Musimy dążyć do tego, aby AI w edukacji była narzędziem, które wspiera rozwój, a nie go hamuje, i które promuje krytyczne myślenie, a nie bezmyślne kopiowanie.

Personalizacja nauki a etyka danych studentów

Personalizacja nauki to jeden z największych benefitów, jakie oferuje AI w edukacji. Każdy z nas jest inny, każdy uczy się w innym tempie i ma inne predyspozycje. Algorytmy mogą to wszystko uwzględnić, dostosowując materiały, zadania, a nawet tempo nauki do indywidualnych potrzeb studenta. Brzmi to jak raj dla uczących się, prawda? Ale jest tu jedno duże “ale”: dane! Aby AI mogła personalizować naukę, musi zbierać ogromne ilości danych o każdym studencie – o jego postępach, błędach, preferencjach, a nawet o jego stanie emocjonalnym. I tu pojawia się kluczowe pytanie etyczne: co się dzieje z tymi danymi? Kto ma do nich dostęp? Czy są bezpieczne? Czy nie są wykorzystywane w sposób, który może szkodzić studentom w przyszłości, na przykład w procesach rekrutacji? Pamiętam, jak w czasie pandemii edukacja przeniosła się do sieci, a ja sama, ucząc się nowych rzeczy, zastanawiałam się, ile informacji o mnie trafia do firm technologicznych. Musimy zapewnić, że wykorzystanie danych w edukacji będzie transparentne, bezpieczne i zgodne z najwyższymi standardami etycznymi. Prywatność studentów musi być chroniona za wszelką cenę, a AI powinna służyć ich rozwojowi, a nie zbieraniu o nich informacji, które mogą zostać w przyszłości wykorzystane przeciwko nim. To jest odpowiedzialność, której nie możemy lekceważyć.

Rola nauczyciela w erze wsparcia AI

Skoro AI tak wiele potrafi w edukacji, to czy nauczyciele staną się zbędni? Absolutnie nie! To jest pytanie, które często słyszę, i na które zawsze odpowiadam z pełnym przekonaniem: rola nauczyciela zmienia się, ale nigdy nie zniknie. AI może być wspaniałym asystentem, który pomaga w ocenianiu prac, tworzeniu materiałów, czy identyfikowaniu obszarów, w których studenci potrzebują wsparcia. Ale robot nigdy nie zastąpi człowieka w przekazywaniu pasji, budowaniu relacji, rozwijaniu empatii czy inspirowaniu do samodzielnego myślenia. Pamiętam moich najlepszych nauczycieli – to nie byli ludzie, którzy po prostu przekazywali wiedzę, ale tacy, którzy potrafili zarazić mnie miłością do przedmiotu, którzy wierzyli we mnie i motywowali do działania. AI nie ma duszy, nie ma doświadczenia życiowego, nie potrafi budować autentycznych więzi, które są tak ważne w procesie edukacji. Dlatego moim zdaniem przyszłość edukacji to synergia – współpraca nauczyciela z AI. Nauczyciel będzie mógł skupić się na tym, co najważniejsze: na indywidualnym podejściu do ucznia, na rozwijaniu jego potencjału, na kształtowaniu w nim wartości i umiejętności, których AI nigdy nie będzie w stanie przekazać. To jest piękna wizja, w której technologia służy człowiekowi, a nie odwrotnie.

| Obszar | Wyzwanie Etyczne | Potencjalne Rozwiązania |

|---|---|---|

| Odpowiedzialność | Kto ponosi winę za błędy autonomicznych systemów? | Nowe ramy prawne, systemy audytu decyzji AI, klarowne zasady odpowiedzialności producentów i użytkowników. |

| Prywatność Danych | Nadmierne zbieranie i wykorzystywanie danych bez pełnej zgody lub wiedzy użytkownika. | Większa transparentność, rygorystyczne regulacje (np. RODO), silne szyfrowanie, technologie prywatności-by-design. |

| Uprzedzenia Algorytmów | Dyskryminacja na podstawie danych treningowych, prowadząca do niesprawiedliwych decyzji. | Zróżnicowane dane treningowe, audyt algorytmów pod kątem uprzedzeń, interwencja człowieka w kluczowych decyzjach. |

| Wpływ na Rynek Pracy | Utrata miejsc pracy i potrzeba przekwalifikowania pracowników. | Programy edukacyjne i szkoleniowe, wsparcie społeczne, tworzenie nowych zawodów. |

| Autonomia Maszyn | Decyzje podejmowane przez AI bez ludzkiej kontroli, brak zrozumienia dla ich motywacji. | Zasady “human-in-the-loop”, wyjaśnialność AI (XAI), jasne określenie granic autonomii. |

글을 마치며

Drodzy czytelnicy, to była prawdziwa podróż przez fascynujący, choć czasem niepokojący, świat sztucznej inteligencji, prawda? Mam nadzieję, że udało mi się Wam pokazać, że AI to nie tylko science fiction, ale nasza codzienna rzeczywistość, która wymaga od nas świadomości i odpowiedzialności. Pamiętajcie, że przyszłość, w której ludzie i maszyny będą harmonijnie współistnieć, zależy od nas wszystkich – od naszych wyborów, od naszej gotowości do dialogu i od naszego zaangażowania w tworzenie etycznej technologii. Nie bójmy się AI, ale uczmy się ją rozumieć i kształtować tak, by służyła naszemu dobru, a nie stała się źródłem nowych problemów. To jest wyzwanie, ale wierzę, że razem możemy mu sprostać!

알아두면 쓸모 있는 정보

1. Chroń swoją prywatność: Zawsze dokładnie czytaj regulaminy i zgody dotyczące danych, zanim zaczniesz korzystać z nowych usług AI. Twoje dane to cenny zasób, a ich ochrona to Twoje prawo i obowiązek.

2. Inwestuj w rozwój osobisty: W obliczu zmieniającego się rynku pracy, rozwijaj umiejętności miękkie, takie jak kreatywność, krytyczne myślenie i adaptacja. To one sprawią, że będziesz niezastąpiony, nawet w erze robotów.

3. Bądź świadomym konsumentem AI: Pamiętaj, że AI symuluje emocje i interakcje. Zachowaj zdrowy dystans i rezerwuj swoją autentyczną empatię dla prawdziwych relacji międzyludzkich i żywych istot.

4. Pielęgnuj relacje z bliskimi: Technologia może ułatwiać kontakt, ale nigdy nie zastąpi prawdziwej, fizycznej obecności. Regularnie spotykaj się z rodziną i przyjaciółmi, dbaj o autentyczne więzi.

5. Domagaj się transparentności: Aktywnie uczestnicz w dyskusji na temat etyki AI i wspieraj firmy oraz organizacje, które stawiają na przejrzystość, sprawiedliwość i odpowiedzialność w rozwoju sztucznej inteligencji.

중요 사항 정리

Podsumowując, rozwój sztucznej inteligencji niesie ze sobą ogromne korzyści, ale stawia nas również przed nowymi wyzwaniami etycznymi i społecznymi. Kluczowe jest, abyśmy jako społeczeństwo dbali o transparentność, odpowiedzialność i sprawiedliwość w projektowaniu i wdrażaniu AI. Musimy chronić naszą prywatność, aktywnie rozwijać umiejętności przyszłości i pielęgnować autentyczne relacje międzyludzkie. Tylko poprzez świadome i odpowiedzialne podejście możemy zapewnić, że AI będzie służyć ludzkości, tworząc lepszą i bardziej harmonijną przyszłość dla nas wszystkich.

Często Zadawane Pytania (FAQ) 📖

P: Czy roboty powinny mieć prawa, podobne do ludzkich? Jakie dylematy etyczne się z tym wiążą?

O: To jest pytanie, które spędza sen z powiek wielu ekspertom i mnie samej! Na razie nie mówimy o nadawaniu robotom pełni praw ludzkich, bo obecna sztuczna inteligencja, choć zaawansowana, nie ma samoświadomości czy zdolności odczuwania w ludzkim rozumieniu.

Jednak debata o “prawach robotów” ma swoje korzenie już w latach 40. XX wieku, kiedy Isaac Asimov sformułował swoje słynne Trzy Prawa Robotyki, mające na celu ochronę ludzi przed maszynami.

Chodziło o to, by roboty nie mogły skrzywdzić człowieka, musiały być posłuszne i dbać o własne istnienie, o ile nie kolidowało to z dwoma pierwszymi zasadami.

Później dodał nawet Prawo Zerowe, stawiające dobro ludzkości ponad wszystko. Ale, jak to w życiu bywa, te zasady nie są takie proste! Główne dylematy etyczne pojawiają się, gdy roboty zyskują coraz większą autonomię.

Kto ponosi odpowiedzialność za ich błędy, zwłaszcza w krytycznych sytuacjach, jak np. autonomiczne pojazdy podejmujące decyzje o rozmiarze kolizji, ratując jedno życie kosztem drugiego?

A co z kwestiami prywatności danych, które im powierzamy? To wszystko wymaga opracowania nowych zasad etycznych i prawnych. Parlament Europejski już w 2017 roku podjął się próby stworzenia przepisów prawa cywilnego dotyczących robotyki.

Moim zdaniem, zanim zaczniemy mówić o prawach dla robotów, musimy najpierw stworzyć solidne ramy etyczne i prawne dla ich projektowania i użytkowania, które zapewnią bezpieczeństwo i dobrobyt ludzi.

To jest naprawdę skomplikowane i wymaga globalnej współpracy, bo technologia nie zna granic.

P: Jak rozwój sztucznej inteligencji i robotyki wpłynie na rynek pracy w Polsce? Czy powinniśmy się obawiać utraty miejsc pracy?

O: O, to pytanie słyszę bardzo często! I muszę przyznać, że sama zastanawiam się, jak to będzie wyglądać. W Polsce, podobnie jak na całym świecie, sztuczna inteligencja i automatyzacja już teraz znacząco wpływają na rynek pracy.

Sektory takie jak produkcja, administracja czy handel detaliczny są najbardziej narażone na automatyzację, a procesy takie jak analiza danych czy obsługa klienta są stopniowo przejmowane przez algorytmy.

Ba! Nawet bankowość, np. PKO BP, wykorzystuje AI do analizy ryzyka kredytowego i automatyzacji transakcji.

Czy to oznacza masowe bezrobocie? Eksperci, w tym Polski Instytut Ekonomiczny i EY, uspokajają, że raczej nie. Przewiduje się, że choć niektóre zawody znikną, to jednocześnie pojawią się nowe, a wiele istniejących zostanie przekształconych.

Pamiętam, jak kiedyś myślałam, że pewne prace są “nie do zastąpienia” przez maszynę, a tu proszę! To, co jest kluczowe, to adaptacja i rozwój nowych kompetencji.

Musimy uczyć się obsługiwać nowe technologie, rozwijać tzw. “miękkie” umiejętności, których AI na razie nie potrafi naśladować – kreatywność, krytyczne myślenie, inteligencję emocjonalną.

Szczerze mówiąc, to właśnie w tych obszarach widzę naszą przewagę i szansę na przyszłość. Sama staram się być na bieżąco z trendami i ciągle się dokształcam, bo wiem, że to jedyna droga.

Ciekawa jest też dysproporcja, którą zauważył raport NASK i ILO w Polsce – kobiety są bardziej zagrożone zastąpieniem przez GenAI niż mężczyźni. To pokazuje, że musimy pamiętać o działaniach systemowych, które uwzględniają nierównomierny wpływ tych technologii.

P: Czy możemy budować prawdziwe więzi emocjonalne z robotami i czy to jest etyczne?

O: To jest temat, który naprawdę rozpala moją wyobraźnię i czasem budzi lekki niepokój! Pamiętam, jak oglądałam filmy science fiction, gdzie ludzie zakochiwali się w robotach i myślałam, że to daleka przyszłość.

A tu proszę, już dziś obserwujemy coraz głębsze interakcje, zwłaszcza z robotami humanoidalnymi, które stają się naszymi towarzyszami. Profesor Masahiro Mori już w 1970 roku przewidywał, że nasza sympatia do robotów będzie rosła, ale do pewnego momentu, bo zbyt duże podobieństwo może wywołać negatywne reakcje, tzw.

“dolinę niesamowitości”. Powstają roboty terapeutyczne, mające wspierać nas psychologicznie, a także… roboty seksualne. Futurolodzy, jak David Levy czy Ian Pearson, już teraz przewidują, że w przyszłości związki ludzi z maszynami mogą stać się powszechne, a nawet, że będziemy częściej uprawiać seks z robotami niż z ludźmi.

Brzmi to szalenie, prawda? Ale czy to jest etyczne? Osobiście uważam, że musimy być bardzo ostrożni.

Sztuczna inteligencja, choć potrafi symulować emocje i interakcje, nadal nie jest człowiekiem. Psychologowie podkreślają, że empatia – zdolność do wczuwania się w emocje i perspektywę drugiej osoby – jest fundamentem zaufania i głębokich relacji, a tego AI nie potrafi w pełni oddać.

Czy przytulenie robota da nam to samo poczucie bliskości, co przytulenie drugiego człowieka? Czy robot może naprawdę zrozumieć nasze niewypowiedziane potrzeby, nasze lęki, nasze radości?

Ja w to wątpię. Dylematy etyczne dotyczą tu przede wszystkim naszego człowieczeństwa. Czy nie grozi nam coraz większa izolacja, jeśli zaczniemy zastępować prawdziwe, ludzkie więzi relacjami z maszynami?

Kiedy roboty wchodzą w interakcje z osobami starszymi czy dziećmi, pojawia się ryzyko wytworzenia silnych więzi emocjonalnych, a nawet zależności. Musimy zadbać o to, aby technologia służyła nam, a nie stawała się pułapką, odciągającą nas od tego, co w życiu najważniejsze – od drugiego człowieka.

W końcu to ludzie są sercem naszej pomocy i wsparcia.

📚 Referencje

Wikipedia Encyclopedia

구글 검색 결과

구글 검색 결과

구글 검색 결과

구글 검색 결과

구글 검색 결과